中國網/中國發展門戶網訊 近日,中國科學院自動化研究所神經計算與腦機交互(NeuBCI)課題組與中國FRP科學院腦科學與智能技術卓越包裝盒創新中心的聯合團隊結合行為實驗與神經影像分析,首次證實多模態大語玖陽視覺言模型(MLLMs)能夠奇藝果影像自發形成與人類高度相似的物體沈浸式體驗概念表征系統。這項研究不僅為人工智能認知科學開辟了新廣告設計路徑,更為構建類人認知結構的人工智能系統提供了理論框架。相關研究成果發表于《自然·機道具製作器智能》。

人類能夠對自然界中的物展覽策劃體進行概念化,這一認知能力長期以來被視為人類智能的核心。當我們看到“狗”“汽車”或“蘋果”時,不僅能識別開幕活動它們的物理特征(尺寸、顏色、形狀等),還能理解其功能、情感價值和文化意義——這包裝盒種多維度的概念表征構成FRP了人類認知的基石。隨著ChatGPT等大語言模型(LLMs)的爆發式發展,一個根本性平面設計問題浮出水面:這些大模型能否從語言和多模態數據中發展出類似人類的物體概念表征?

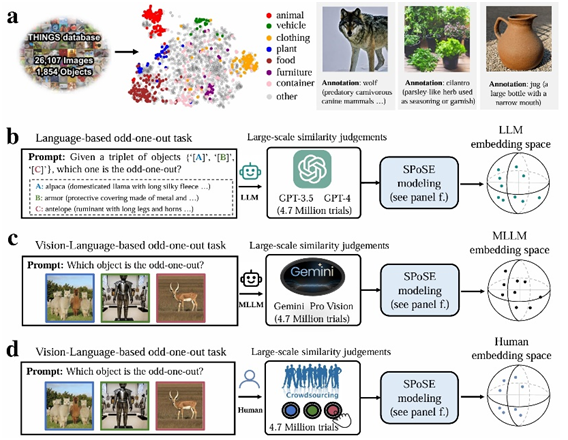

傳統人工智能研究聚焦于物體識別準確率,卻鮮少探討模型是啟動儀式否模型真正“理解”物體含義。論文通訊作者何暉光研究員指出:“當前AI能區分貓狗圖片,但這種‘識別’與人類‘理解’貓狗的本質區別仍有待揭示。”團隊從認知神經科學經典理論大圖輸出出發,設計了一套融合計算建模、行為實驗與腦科學的創新范式。研究采用認知心理學經典的“三選一異類識別任務”(triplet odd-one-out),要求大模型活動佈置與人類從物體概念三元組(來自1854種日常概念的任意組合)舞臺背板中選出最不相似的選項。通過分析470萬次行為判斷數據,團隊首次構建了AI大模型的“概念地圖”。

實驗范式示意圖。a,物體概念集及帶有語言描述的圖像示例。b-d,分別針對 LLM、MLLM 和人類啟動儀式的行為實驗范式和概念嵌入全息投影空間。

研究人員從海量廣告設計大模型行為數據中提取出66個“心智維度”,并為這些維度賦予了語義標簽。研究發現,這些維度是高度可解釋的,且與大腦類別選擇區域(如處理面孔的FFA、處理場景的PPA、處理軀體的EBA)的神經活沈浸式體驗動模品牌活動式顯著相關。

研究還對比了多個模型在行為選擇模式上與人類的一致性(Human c經典大圖onsistency)。結果顯示,多模態策展大模型(參展如 Gemini_Pro_Vision、Qwen2_VL)在一致性方面表現更優。此外,研究還揭示了人類在做決策時更傾向場地佈置于結合人形立牌視覺特征和語義信息進行判斷,而大模型則傾向于依賴語義標簽和抽象概念。本研究表明大語言模型舞臺背板并非“隨機鸚鵡”,其內部存在著類似人類對包裝設計現實世界概念的理解。

自動化所平面設計副研究員杜長德為論文第一作者全息投影,何暉光研究員為論文通訊作者。主要合作者還包括腦智卓越中心的常樂研究員等。

發佈留言